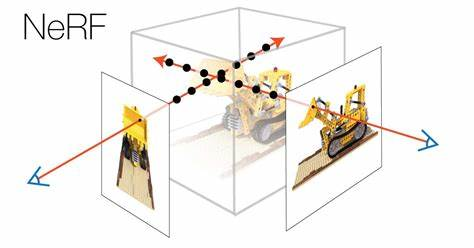

论文专题阅读:可编辑的 NeRF

毕设选题为 NeRF 相关,研究生实验室也有相关内容。将最近读的一些论文笔记放在这里。

NeuTex: Neural Texture Mapping for Volumetric Neural Rendering (CVPR 2021)

结果

能够在使用神经辐射场重建三维模型的同时,重建出 UV 纹理映射,使得模型的纹理可以像传统网格那样进行编辑。

方法

将几何信息与纹理信息解耦。创建两个新网络:

关于训练方法,NeuTex 提出借鉴 AtlasNet 的方法来实现训练网络将 UV 坐标映射到 3D 位置的方法。

再由基本 NeRF 的网络公式可以得到:

于是需要训练三个组件:

但只是这样很容易出现纹理映射严重失真的问题。这是因为缺乏了对映射一致性的验证,导致退化的纹理映射,无法展开三维表面。

因此我们再加一个组件:

用以约束映射尽为一对一的关系,以此实现高质量纹理映射。

不足

- 训练质量不高。至少不比最原始的 NeRF 更好。

- 对细粒度几何的映射质量较差。

NeuS: Learning Neural Implicit Surfaces by Volume Rendering for Multi-view Reconstruction

结果

一种新的基于 SDF 的三维表面重建。

因为能重建表面,对于生成 mesh 具有重要意义。

方法

定义两个 components:

表示空间中一点到表面的 SDF 值。

表示坐标及视角约束下的点颜色。

渲染方面,与辐射场渲染不同,公式为

NeRF 中是 $T(t)\sigma({\bold r}(t))$,透射率乘以体积密度. NeuS 中替换为一个暂定权重函数 $w(t)$,$w(t)$ 被要求:(1)在物体表面上推导出的值为 $0$,即表面后的内容都对屏幕颜色无贡献;(2)如果有两个点 SDF 值相同,距离相机近的权重更大。

如果使用 $T(t)\sigma({\bold r}(t))$,则不能保证 SDF 不产生偏差(没弄懂)。

因此使用 $T(t)\rho(t)$ 代替之,其中 $T(t)=\exp(-\int_0^t\rho{(u){\rm d}u})$.

而

,这样即可满足前面两个条件。

NeuMesh: Learning Disentangled Neural Mesh-based Implicit Field for Geometry and Texture Editing (ECCV 2022 Oral)

结果

提供一种新颖的隐式表达,来在进行神经渲染重建的同时提供编辑功能。能够同时拥有照片级真实质量和多种方式的编辑支持。

方法

- 使用 NeuS 重建出表面模型后,再使用 Marching Cubes 进行 mesh 分割。

- 为每个顶点存储一组可学习参数

不足

纹理编辑方法比较 trial, 这种编辑方法至少目前看来是不太适合摆上工作流的,还是与传统网格编辑方法差远了。论文作者竟然说基于拍摄图像直接进行纹理编辑的方法要比 NeuTex 的基于 UV 编辑更方便……啊啊?。

Wonder3D: Single Image to 3D using Cross-Domain Diffusion (arXiv 2023)

结果

单张图重建出可替换 texture 的 mesh..

方法

先用 2d diffusion 进行新视角合成,处理出多个视角的法线与颜色,再进行神经隐式场还原。

不足

提出了一个 new distribution.

不是很理解为什么不使用 单图->多视角贴图->NeRF/NeuS生成 的 pipeline,说是这样对模型的泛化效果不行,会局限于几种基础模型?但这不是 NeRF 已经解决的东西吗。